PIX 1.1. Les moteurs de recherche explorent constamment le web pour découvrir les pages. On parle de "collecte" ou "crawling". Comment s'appelle le processus qu'utilisent.

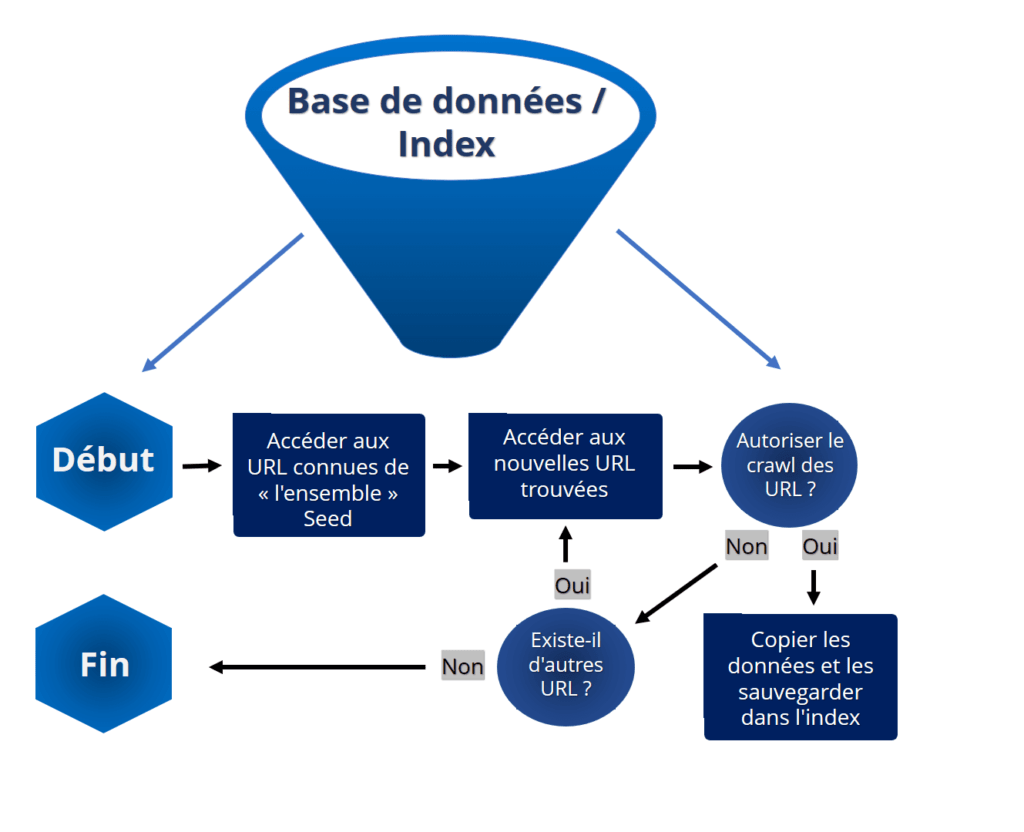

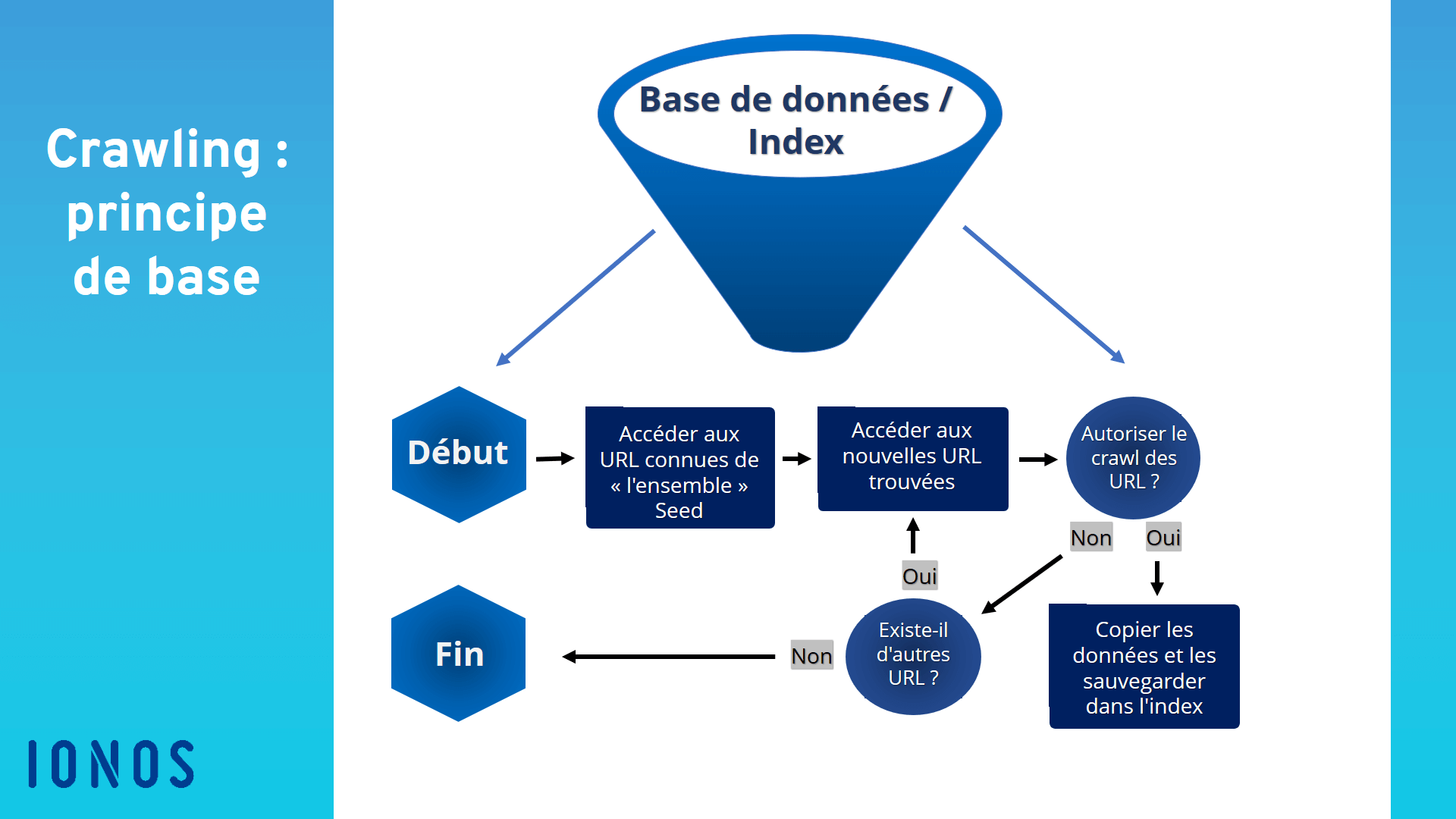

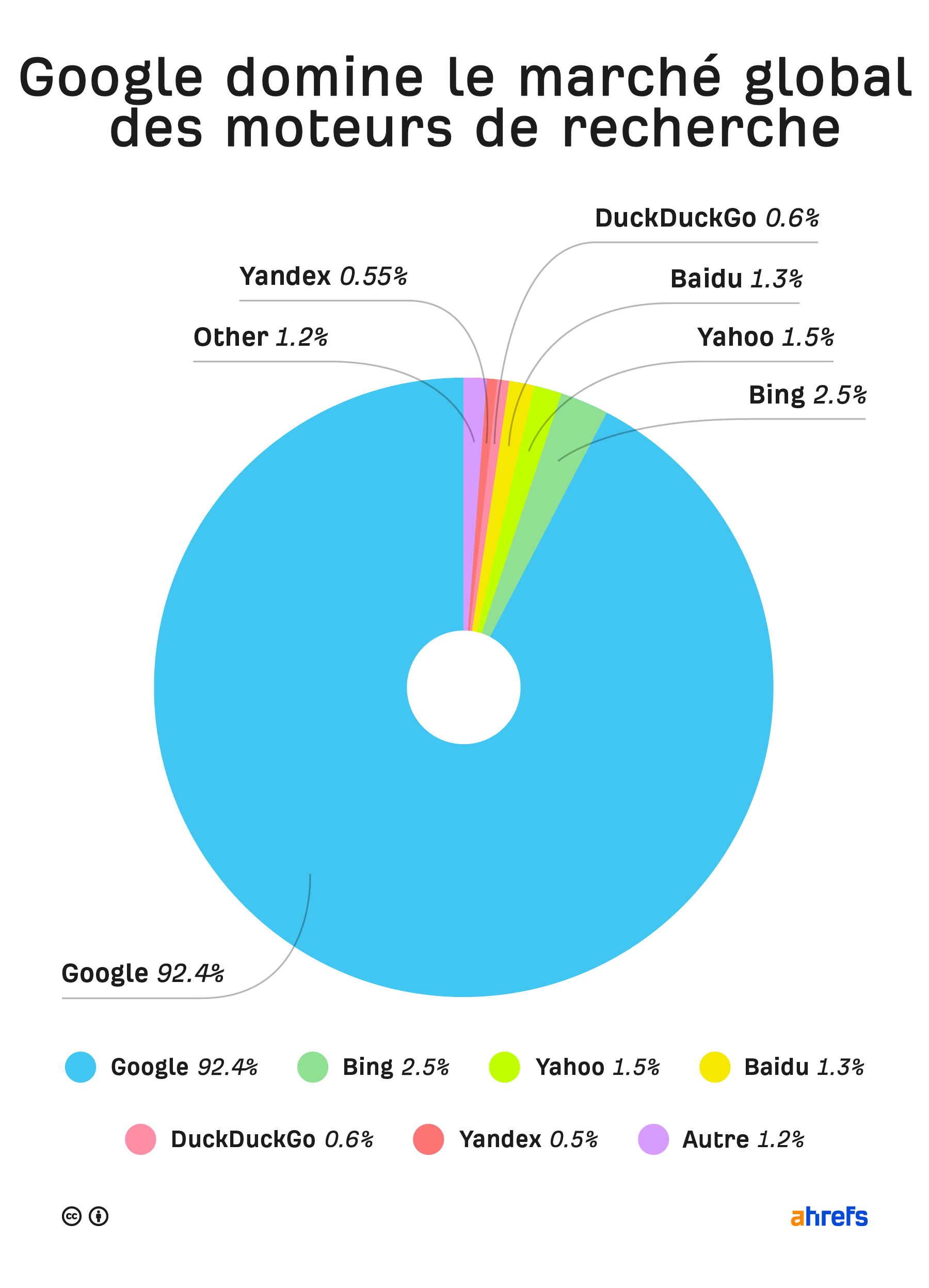

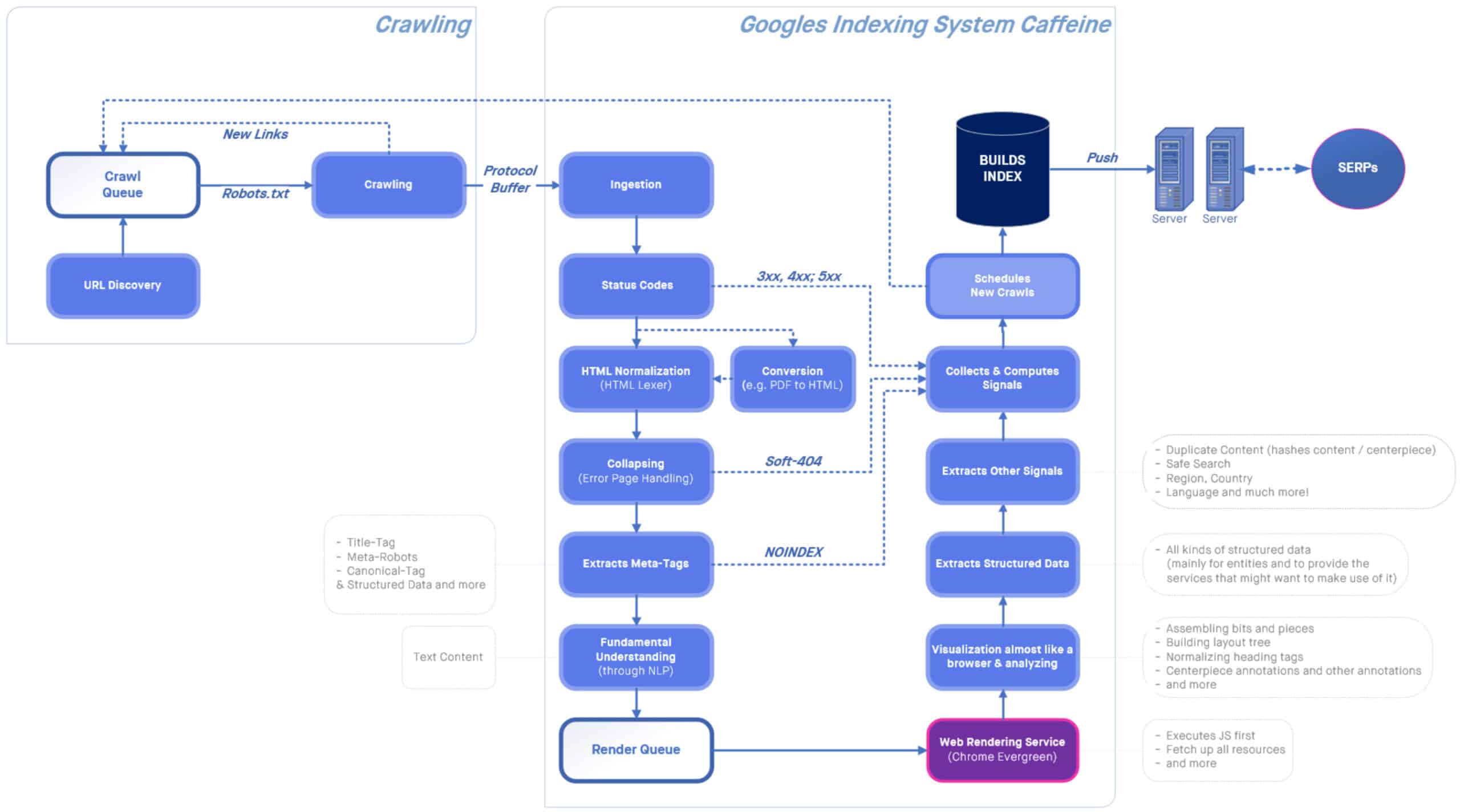

Un moteur de recherche comme Google fonctionne grâce à un grand nombre de serveurs appelés spiders, robots ou crawlers qui sont chargés de parcourir les liens des millions.

NosDevoirs.fr est un service gratuit d'aide aux devoirs, du groupe Brainly.com. C'est un portail d'entraide, de coopération, d'échange d'idées.

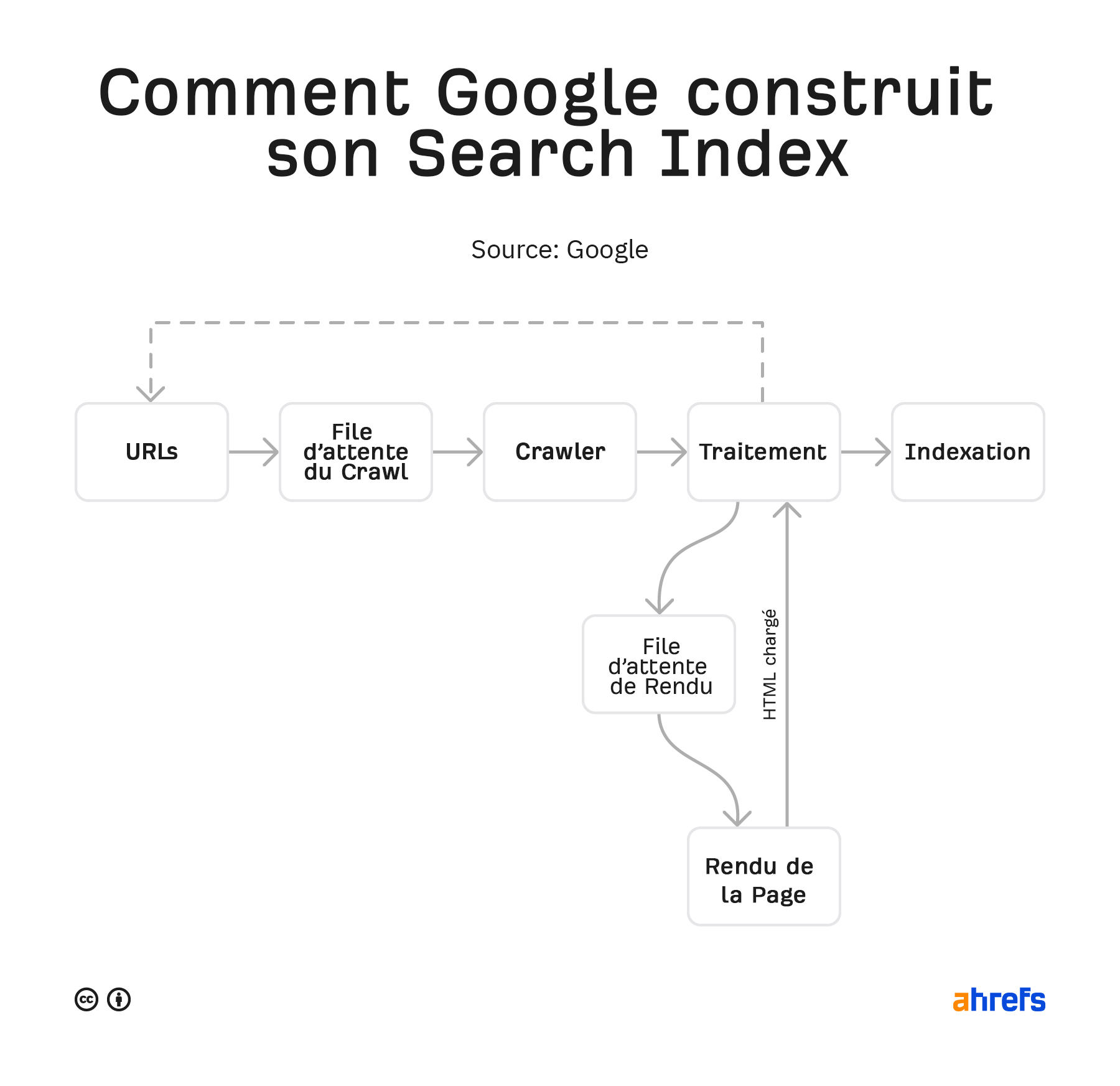

Le crawling est le processus qu’utilisent les moteurs de recherche pour extraire et évaluer les mots des pages web afin de pouvoir répondre aux requêtes des.

L'activité de crawling d'un moteur de recherche désigne le processus par lequel un moteur va explorer et indexer les différents contenus rencontrés sur Internet en général ou sur.

La collecte automatisée de données : Crawling & Scraping. Aujourd’hui, il est indéniable que les nouvelles technologies prennent une place de plus en plus importante dans.

Les moteurs de recherche explorent constamment le web pour découvrir les pages. On parle de “collecte” ou “crawling”. Comment s’appelle le processus qu’utilisent les.

Le crawling permet de maintenir votre notoriété et votre référencement grâce aux visites fréquentes des robots d’indexation. Aussi pour améliorer la position de votre page, ce.

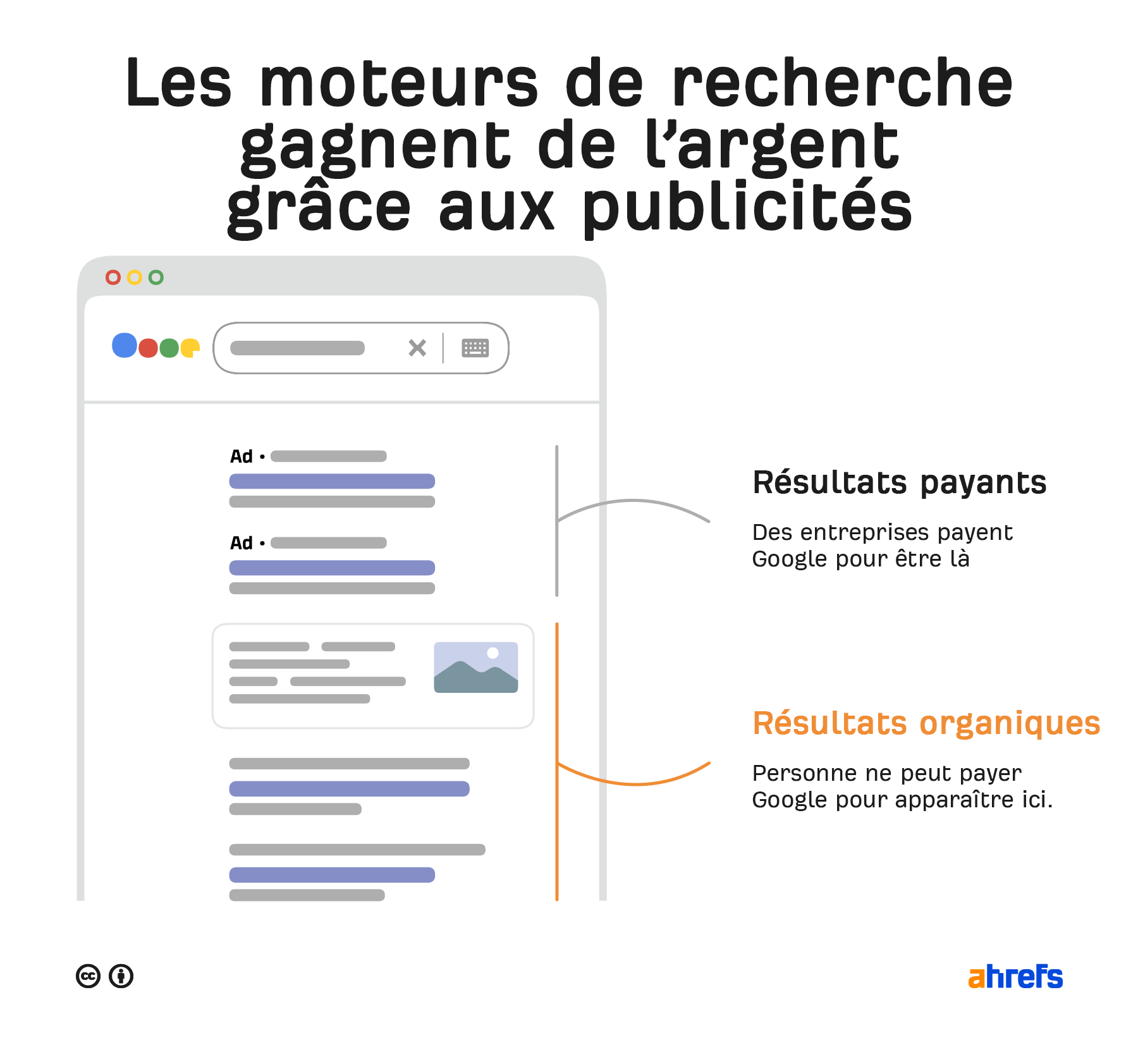

Crawling et indexing. Les moteurs de recherche (search engine) servent à une seule chose : fournir des réponses aux questions des utilisateurs. Pour fournir des résultats de.

Les processus qu’utilisent les moteurs de recherche pour extraire et évaluer les mots des pages web se font par la voie du crawling et l’indexation. Tout d’abord, un.

On désigne par scraper le nom du programme qui effectue cette action. Contrairement à un crawler (programme vu plus haut) qui découvre lui-même les sites parcourus et les.